Microsoft w ciągu trzech lat zamierza zaoferować komercyjny system, przechowujący dane w DNA. Odpowiednio zmodyfikowany materiał genetyczny może stać się niewiarygodnie pojemnym nośnikiem danych. Co powiecie na odpowiednik 687* standardowych dysków o wielkości 1 mm3? Ale kwas deoksyrybonukleinowy ma też swoje wady.

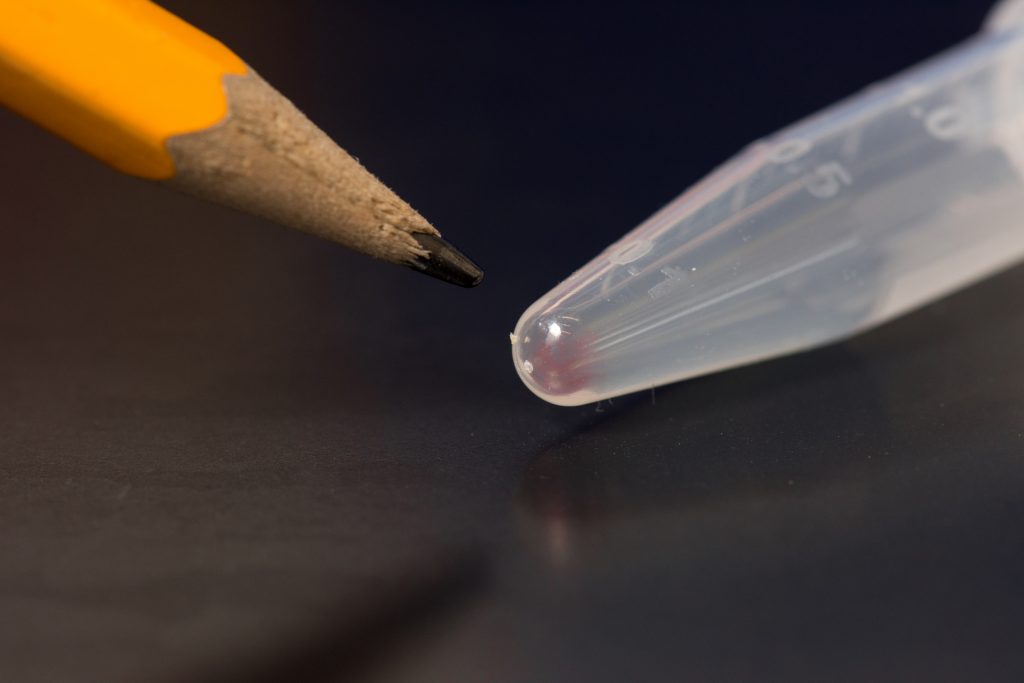

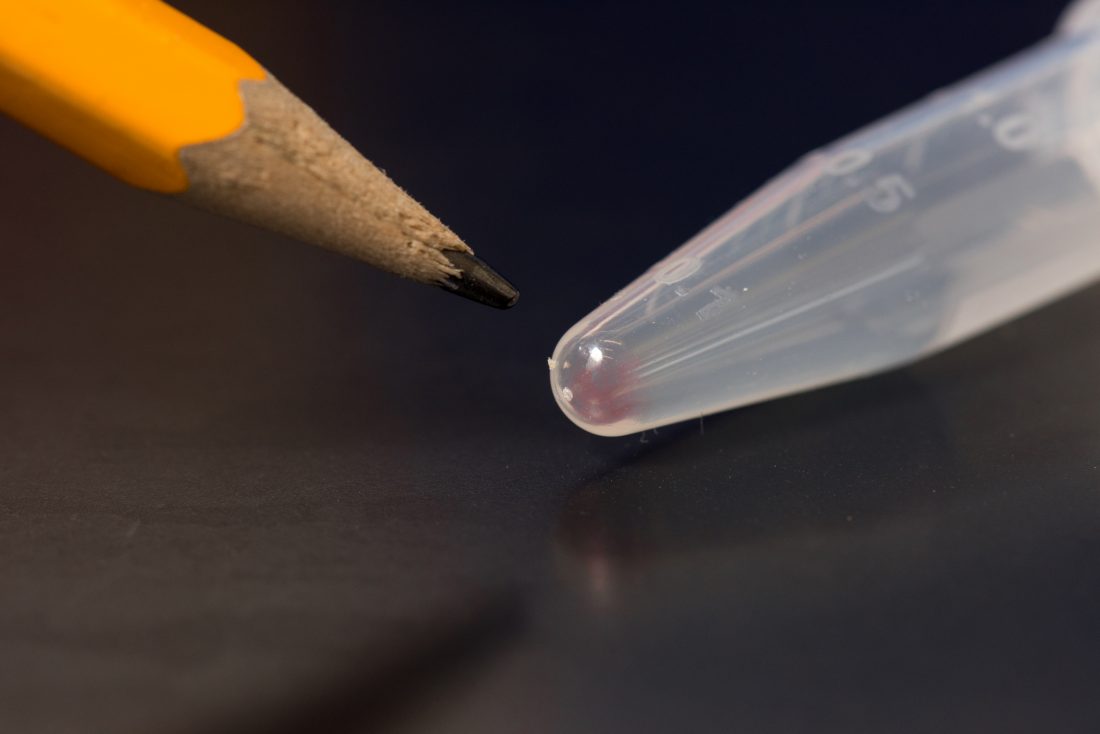

Ta różowa plama to DNA, mogące przechować 600 GB danych (zdjęcie: Tara Brown Photography/ University of Washington)

Według danych IDC ilość wyprodukowanych i przechowywanych przez nas danych w 2020 roku sięgnie 44 trylionów gigabajtów (44 zetabajty). Już sama ta informacja pokazuje, że potrzebujemy skutecznego, trwałego i niezwykle pojemnego nośnika danych, który pozwoliłby zarchiwizować świat dla przyszłych pokoleń. Naukowcy od lat szukają metod, które pozwolą zrealizować ten cel. Zgodnie z informacją, opublikowaną przez MIT Technology Review, do końca dekady Microsoft planuje uruchomić komercyjnie dostępne urządzenia przechowujące dane w DNA.

Dlaczego DNA?

DNA jest najgęstszym nośnikiem informacji znany ludzkości. Jak gęstym? Tego nie da się jednoznacznie powiedzieć. Przytaczane w różnych publikacjach dane odbiegają od siebie, ale kiedy się je sobie uzmysłowi to i tak trudno otrząsnąć się z wrażenia. Nie można przecież przejść obojętnie obok informacji, że wszystkie filmy jakie wyprodukował człowiek miały by się zmieścić w czymś wielkości kostki cukru. I nie ma znaczenia, że raz jest to 215 petabajtów, raz „prawie zetabajt” (trylion gigabajtów), jakie teoretycznie możemy zmieścić w 1 gramie DNA.

Zaletą kwasu deoksyrybonukleinowego jest też jego trwałość. W przeciwieństwie do płyt DVD, twardych dysków, napędów taśmowych, materiał DNA przechowywany w chłodnym i suchym miejscu może przetrwać tysiąclecia – co potwierdza analiza materiału genetycznego szczątków neandertalczyka sprzed 430 000 lat znalezionego w Hiszpanii. Trzymane w temperaturze -18 °C i laboratoryjnych warunkach mogą być użyteczne za ponad dwa miliony lat.

Poza tym, w przypadku DNA nie ma ryzyka, jakie wiąże się na przykład z wykorzystaniem napędów taśmowych – z dużym prawdopodobieństwem można założyć, że za 100 czy 200 lat nie będziemy mieli czym odczytać zapisanych na nich danych. Będzie wręcz odwrotnie, w przyszłości powinniśmy to robić wygodniej i sprawniej.

Prace trwają od 1988 roku

Pierwszą osobą, która zapisała dane w DNA, był Joe Davis. Artysta razem z naukowcami z Harvard Medical School zakodował w sekwencji DNA obrazek przedstawiający starogermańską runę. Informacja o białych i czarnych pikselach zajmowała tylko 35 bitów i została wstrzyknięta do bakterii E. coli. W 2012 roku zespół genetyków z tej samej uczelni, kierowany przez George’a Churcha i Sri Kosuri zapisał w DNA książkę, liczącą 52 000 słów, 11 obrazków JPG i kod wirusa napisany w JavaScripcie.

W ubiegłym roku poprzeczka poszła jeszcze wyżej: badacze pracujący w Microsoft Research i University of Washington „nagrali” na DNA 200 megabajtów – w tym poniższe wideo. W teorii, w pojedynczym nukleotydzie można zakodować 2 bity. Dawałoby to pojemność rzędu 455 eksabajtów na gram materiału DNA. W praktyce algorytmy kodowania nie są na tyle efektywne. Metoda użyta przez Churcha i Kosuri umożliwiała zapisanie jedynie 1,28 petabajta danych na gram. Kolejne eksperymenty przesuwały tę granicę, ale nikomu poza zespołem Yaniva Erlicha i Diny Zielinski z Columbia University, nie udało się zbliżyć nawet do połowy teoretycznych możliwości, które wynoszą ok. 1,8 bita danych na nukleotyd DNA. Trzeba dodać, że 2 bity nigdy nie będą możliwe z powodu pojawiających się sporadycznie błędów zapisu i odczytu. Parze naukowców udało się osiągnąć rezultat 1,6 bita na nukleotyd.

Jak to – w dużym uproszeniu – działa

Jeśli pamiętacie z lekcji biologii, DNA zbudowana jest z czterech związków chemicznych: adeniny, cytozyny, guaniny i tyminy (ACGT), które połączone są ze sobą w charakterystyczny, można powiedzieć zaprogramowany sposób. Pierwszym etapem jest przełożenie cyfrowych treści zapisanych w postaci 0 i 1 na ciąg znaków ACGT. Następnie mogą być one dzielone na fragmenty i uzupełniane o dodatkowe informacje, które opisują jego lokalizację w pliku wyjściowym.

W kolejnym kroku, sekwencje DNA są rzeczywiście „produkowane” i umieszczane w probówce. Żeby je odczytać potrzeba sekwensera DNA, który rozpoznaje sekwencje ACGT i komputera, zmieniającego je z powrotem na wartości binarne oraz korygującego błędy. Bardzo istotne jest też, że naukowcom z Microsoft Research udało się też opracować dostęp sekwencyjny. Oznacza to, że nie muszą analizować całego materiału, żeby odczytać potrzebny fragment danych.

W przeciwieństwie do innych futurystycznych metod przechowywania danych, wszystkie operacje związane z zapisem, odczytem czy przechowywaniem danych w nukleotydach odbywają się w temperaturze pokojowej, a nie np. w środowisku chłodzonym ciekłym azotem.

Są też minusy

Operacja zapisu danych w DNA jest bardzo powolna. Prędkość na poziomie 400 bitów na sekundę to zdecydowanie za mało, by mówić o swobodnym dostępie do danych. Kolejny problem to fakt, że każda operacja sekwencjonowania DNA niszczy wejściowy materiał. Oznacza to, że im częściej je odczytujemy, tym mniej go zostaje na kolejny raz. By tego uniknąć trzeba kopiować DNA, co jest stosunkowo proste, ale rodzi inne komplikacje, bo może wprowadzać błędy.

Ale to wszystko to tylko kłopoty techniczne. Prawdziwym wyzwaniem, jakie stoi przed nowym sposobem przechowywania danych jest obniżenie kosztów stworzenia syntetycznego DNA i procesu jego odczytu. Na chwilę obecną jest mowa o kwocie ok. 3500–4500 dolarów za 1 MB danych. Pociechą ma być fakt, że odczytanie ludzkiego genomu w 2007 roku kosztowało 10 milionów dolarów. Dziś da się to zrobić za 1000 USD.

Źródła: zaznaczone w tekście oraz UW Today, Microsoft Blog.

Zdjęcie na otwarciu: Nogas1974/Wikimedia (CC BY-SA 4.0)

* Dane za tym źródłem; jako standardową pojemność dysku przyjąłem 1 TB.

You must be logged in to post a comment.