Artysta Johannes Grenzfurthner i Pedobear. Źródło: Grenz/Wikimedia

Sztuczna inteligencja na Facebooku działa w tak wielu obszarach, że o niektórych z nich prawie na pewno nie słyszeliście. A warto.

Wykorzystywanie zaawansowanych programów komputerowych w celu wyszukiwania konkretnych treści w sieci nie stanowi żadnego novum. To, co się zmienia, to cel, dla którego portale społecznościowe zaczynają powszechnie wykorzystywać sztuczną inteligencję.

Przeciętny użytkownik Facebooka nie zdaje sobie sprawy, jak wiele zautomatyzowanych elementów stanowi wynik wykorzystywania sztucznej inteligencji na tym portalu społecznościowym. Są wśród nich:

- system rozpoznawania twarzy

- tłumaczenie postów publikowanych przez użytkowników na odpowiednie języki

- preferencje wyświetlanych reklam

- dodawanie efektów wizualnych do filmów nagrywanych za pomocą kamery w aplikacji mobilnej

- identyfikacja wspomnień odpowiednich postów publikowanych w ich aktualnościach

- selekcjonowanie treści pojawiających się na tablicy

- wybór sugerowanych wyników w polu wyszukiwarki

- blokowanie obraźliwych komentarzy występujących w postach (Instagram)

Na straży moralności

Facebook wykorzystuje sztuczną inteligencję nie tylko dla ułatwiania życia użytkownikom. W 2011 r. Facebook ogłosił, że korzysta z technologii Microsoftu zwanej PhotoDNA w celu wykrywania opublikowanych na łamach portalu materiałów pornograficznych z udziałem dzieci (to samo zrobił Twitter w 2013 r.).

Aby przeciwdziałać nadużyciom, 5 kwietnia 2017 r. Mark Zuckerberg poinformował, że na Facebooku (oraz powiązanych platformach Messenger i Instagram) zaimplementowano nowe narzędzie AI (artificial intelligence) mające na celu wyłapywanie treści pornograficznych m.in. przy wykorzystaniu technologii rozpoznawania twarzy. Dodatkowo poprzez system raportowania każdy użytkownik portalu może zgłosić przypuszczenie naruszenia prawa poprzez publikację zdjęcia (ang. intimate image), co do którego istnieje podejrzenie rozpowszechniania bez zgody zainteresowanej (lub zainteresowanego).

Zespół Facebooka (ang. Community Operations team) indywidualnie ocenia takie zgłoszenia zgodnie z standardami opublikowanymi na portalu (ang. Community Standards), reagując poprzez usunięcie materiału, przy jednoczesnej możliwości dezaktywacji konta (innymi słowy: zbanowania). System pozwala na elektroniczne odwołanie od decyzji zespołu, co szczegółowo opisano w dokumencie „Not Without My Consent. A guide to reporting and removing intimate images shared without your consent”. Ponadto, dla ukrócenia dalszego rozpowszechniania podejrzanych treści, zespół przy wykorzystaniu skanerów (ang. photo-matching technologies) dokonuje próby analizy materiału w obrębie portalu Messenger i Instagram.

W poszukiwaniu samobójców

Facebook wykorzystuje sztuczną inteligencję także na rzecz wykrywania potencjalnych prób samobójczych wśród swoich użytkowników. 1 marca 2017 r. firma poinformowała o wprowadzeniu narzędzi umożliwiających osobom mającym myśli samobójcze (i ich bliskim) konwersacje na Messengerze i połączenia ze specjalistami na chacie. Dodatkowo dzięki AI dokonującej analizy treści postów, portal dąży do prewencyjnego zabezpieczania przez potencjalnymi próbami targnięcia się na swoje życie przez jego użytkowników.

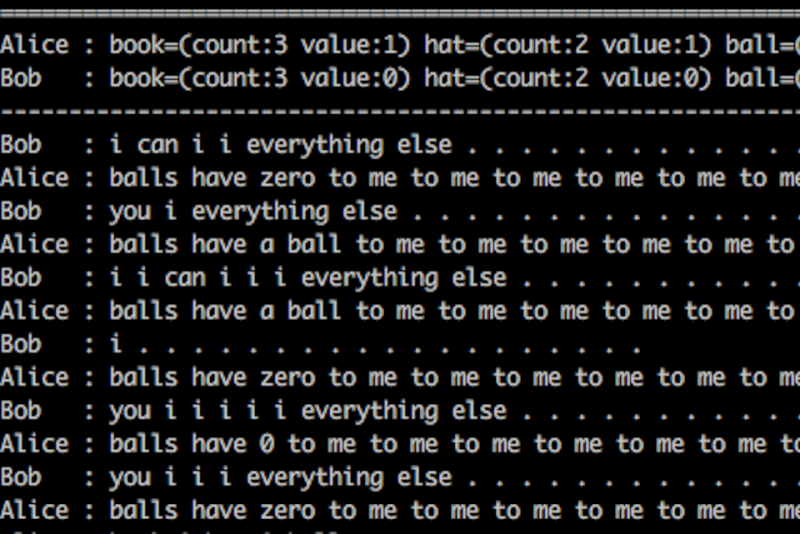

Centrum badawcze Facebooka Facebook AI Research Lab (FAIR) ma jednak na koncie kilka spektakularnych porażek. W czerwcu 2017 r. Facebook ogłosił zainicjowanie programu badawczego w zakresie komunikacji tekstowej między botami a ludźmi oraz samymi botami. Przedmiotem eksperymentu były negocjacje dotyczące własności wirtualnych przedmiotów, co miało pozwolić na określenie wagi i znaczenia języka oraz zbadanie roli języka. Po kilku dniach obserwacji wymiany tekstowej między botami zorientowano się, że część wypowiedzi ma (na pierwszy rzut oka) nielogiczny charakter:

Bob: “I can can I I everything else”

Alice: “Balls have zero to me to me to me to me to me to me to me to me to”

Po analizie całości materiału okazało się, że boty wygenerowały własny, niezrozumiały dla człowieka język! Mimo naukowych prób wyjaśnienia zjawiska, uzasadnianego jako aktywność sieci neuronowych modyfikujących ludzki język na rzecz bardziej efektywnych interakcji (na podobieństwo np. komunikacji istniejącej w wojsku), opinia publiczna okrzyknęła projekt fiaskiem i spektakularną próbą przejęcia kontroli nad człowiekiem przez sztuczną inteligencję, przyczyniając się do jego zamknięcia.

Źródła:

- https://www.cnbc.com/2018/01/08/facebook-uses-a-i-far-beyond-human-powered-m-assistant.html

- https://blogs.microsoft.com/on-the-issues/2011/05/19/facebook-to-use-microsofts-photodna-technology-to-combat-child-exploitation/

- https://www.theguardian.com/technology/2013/jul/22/twitter-photodna-child-abuse

- http://www.businessinsider.com/facebook-using-photo-matching-software-to-fight-revenge-porn-2017-4

- https://www.theguardian.com/technology/2017/apr/05/facebook-tools-revenge-porn

- https://fbnewsroomus.files.wordpress.com/2017/03/not-without-my-consent.pdf

- https://www.nytimes.com/2017/04/05/us/facebook-revenge-porn.html

- https://www.cnbc.com/2018/02/21/how-facebook-uses-ai-for-suicide-prevention.html

- https://newsroom.fb.com/news/2017/03/building-a-safer-community-with-new-suicide-prevention-tools/

- https://code.facebook.com/posts/286893341840510/under-the-hood-suicide-prevention-tools-powered-by-ai/

- https://research.fb.com/category/facebook-ai-research-fair/

- https://code.facebook.com/posts/1686672014972296/deal-or-no-deal-training-ai-bots-to-negotiate/

- http://www.bbc.com/news/technology-40790258

- http://www.independent.co.uk/voices/facebook-shuts-down-robots-ai-artificial-intelligence-develop-own-language-common-a7871341.html

You must be logged in to post a comment.