Wystarczy skierować kamerę telefonu na dowolny obiekt by usłyszeć jak on się nazywa w innym języku. Tak działa projekt Thing Translator, którego każdy może spróbować.

Tłumacza wizualnego wymyślonego przez Dana Motzenbeckera można znaleźć na platformie A.I. Experiments. Jest to miejsce gdzie każdy może umieścić własny pomysłowy projekt, o ile tylko w swoim działaniu wykorzystuje on deeplearningową chmurę obliczeniową Google’a.

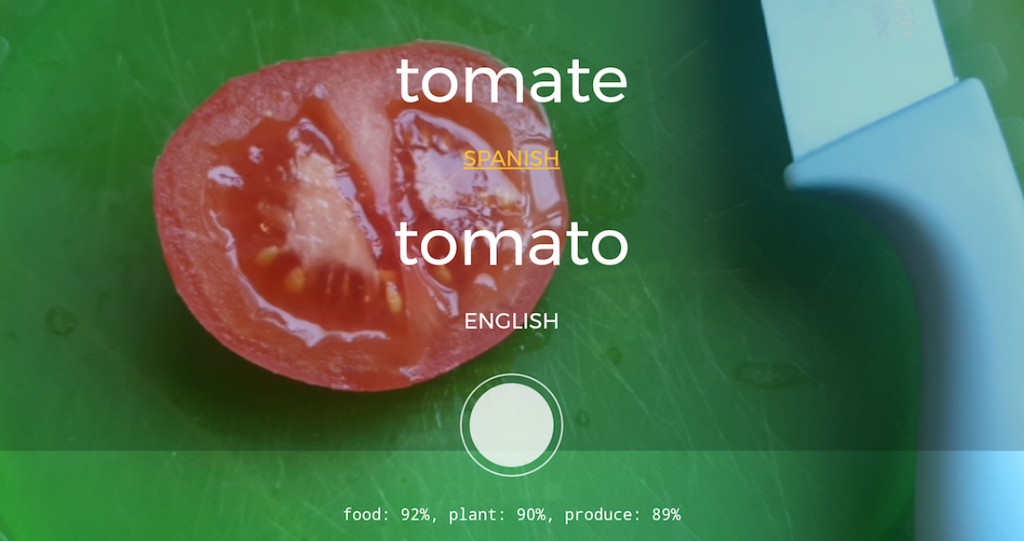

Zasada działania Thing Translatora jest prosta: zdjęcie rzeczy, którą chcemy przetłumaczyć, następnie wysyłane jest do Cloud Vision API, czyli sieci neuronowej rozpoznającej i klasyfikującej obrazy. Najbardziej prawdopodobny rezultat trafia do „silnika” Google’a odpowiadającego za tłumaczenie – Translate API – i wraca na nasz telefon.

Mechanizm swoim działaniem bardzo przypomina mi to, co ma już niebawem przynieść Google Lens, ale w odróżnieniu do niego tego translatora możecie już teraz sami spróbować. Jedyny wymóg to posiadanie telefonu lub tabletu działającego pod kontrolą Androida, na którym klikniecie ten link.

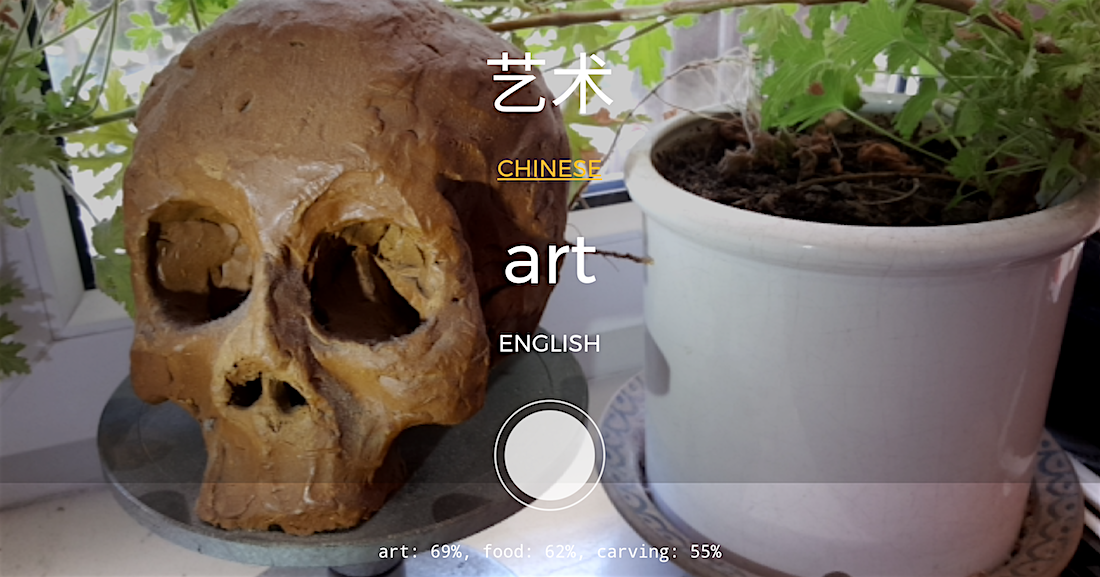

Na razie to tylko demonstracja możliwości. Wygląda na to, że algorytmy wybierają najwyżej punktowane słowa skojarzone z obrazem. Nie zawsze są to najszczęśliwsze wybory i często te właściwsze znajdują się na drugim czy trzecim miejscu. Poniższe tłumaczenie udało mi się uzyskać za dziesiątym podejściem, wcześniejsze wyniki informowały mnie, że to żywność, produkcja (chyba nóż sugerował robienie kanapki), zielony, a po oddaleniu miało być to danie. Natomiast widelec został rozpoznany i przetłumaczony bezbłędnie. Zachęcam do eksperymentowania 🙂

You must be logged in to post a comment.