Dzięki Google Lens telefon zrozumie, co widzi i zapyta nas co ma z tym zrobić. Technologia może być dostępna na naszych telefonach jeszcze w tym roku.

Podczas konferencji Google I/O szef korporacji, Sundar Pichai, zaprezentował jak działa połączenie wirtualnego asystenta (właściwie asystentki) z wbudowanym w telefon aparatem. Dzięki technologii Lens, która bazuje na uczeniu maszynowym, aplikacja Google Photos analizuje to co widzi i wyświetla powiązane z tym informacje.

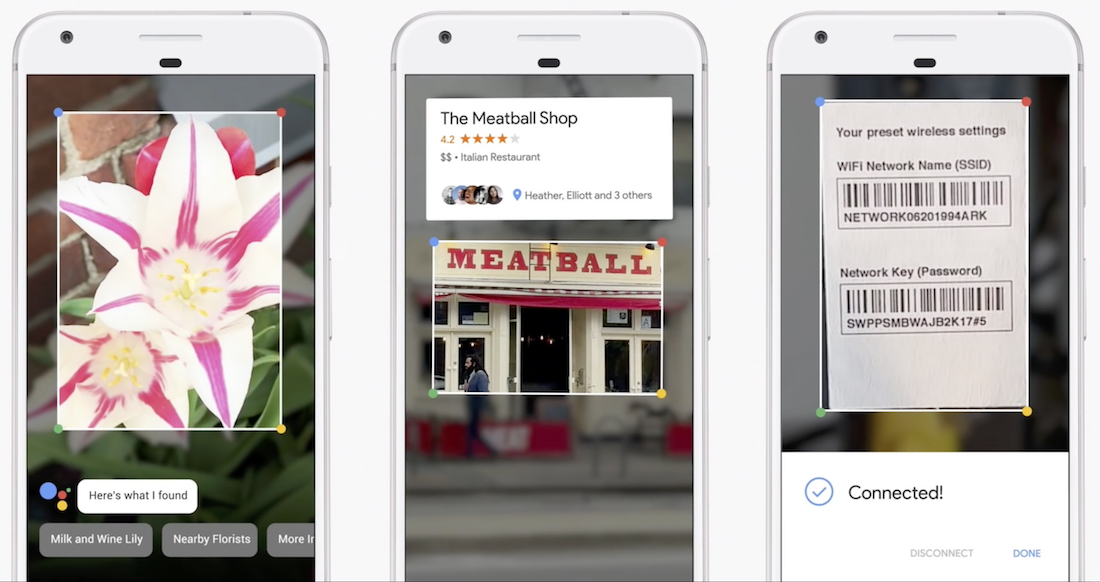

Podczas prezentacji mogliśmy zobaczyć tylko szczyptę możliwości Google Lens. Pierwsze demo pokazało, że za pomocą aparatu możemy poznać nazwę kwiatu. Zakładam, że tak samo rozpoznamy też zwierzęta np. ptaki.

Podczas prezentacji mogliśmy zobaczyć tylko szczyptę możliwości Google Lens. Pierwsze demo pokazało, że za pomocą aparatu możemy poznać nazwę kwiatu. Zakładam, że tak samo rozpoznamy też zwierzęta np. ptaki.

Drugi przykład polegał na skierowaniu aparatu na tabliczkę znamionową rutera. Google Photos nie tylko rozpoznał umieszczone tam ciągi liter i cyfr, ale od razu zapytał czy połączyć z tym ruterem nasz telefon!

Kolejny przykład pokazywał, jak błyskawicznie uzyskać informacje o restauracjach nie robiąc nic więcej poza skierowaniem na nie komórki.

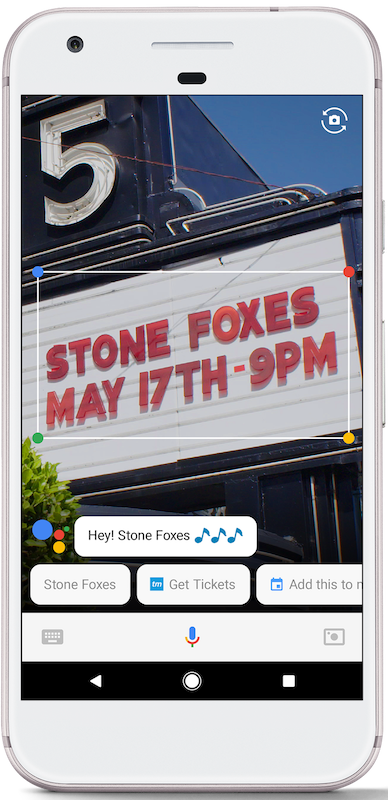

Według Sundara Pichaia fakt, że komputer „rozumie” obrazy i filmy jest bazą do rozwoju wizji sztucznej inteligencji, która ma być przyszłością Google’a. Dlatego Lens ma pojawić się nie tylko w aplikacji do robienia zdjęć, ale też w działającym Asystencie. Już za kilka miesięcy będziemy mogli pokazać mu np. wiszący na ulicy plakat zapowiadający koncert i powiedzieć, żeby zapisał jego datę w naszym kalendarzu czy zamówił bilety.

Lens uprości również tłumaczenia. Wystarcz skierować aparat smartfona na np. menu w restauracji, a Asystent automatycznie rozpozna obcy język i zaproponuje, że może je dla nas przetłumaczyć. Kiedy wybierzemy jakieś danie, możemy nawet poprosić o wyświetlanie jak ono wygląda. Najbardziej interesujące jest to, że cała ta operacja może odbyć się bez podawania nazwy dania. Źródłem wiedzy dla Asystenta będzie tylko obcojęzyczna treść widziana przez obiektyw aparatu. Zobaczcie zresztą sami:

Szef wyszukiwarkowego giganta powiedział, że z Lens będziemy mogli korzystać „wkrótce”. Muszę przyznać, że czekam na niego z niecierpliwością, bo często sięgałem po stare i dawno nie aktualizowane Gogle czyli Google Goggles – poprzednią aplikację, która próbowała rozpoznać, co widzi aparat. Ten algorytm sprawdzał się doskonale np. w zagranicznych muzeach, by szybko dowiedzieć się więcej o oglądanym obrazie. Niestety nie był nie omylny, ale dziś Google twierdzi, że jego najnowsze algorytmy rozpoznawania obrazów są już skuteczniejsze od człowieka. Dlatego tym bardziej z chęcią to sprawdzę.

Źródło, zdjęcia: Google I/O 2017

You must be logged in to post a comment.